La vraie faille du cloud hybride n’est pas technologique, mais stratégique : elle se situe aux points de jonction mal maîtrisés entre vos infrastructures publiques et privées.

- Les configurations réseau par défaut, comme le « tromboning », peuvent doubler la latence de vos applications critiques en créant des trajets de données inutiles.

- Une migration d’applications vers l’hybride sans une méthode rigoureuse comme le « Strangler Fig Pattern » garantit quasiment des pertes de données ou des interruptions de service.

Recommandation : Auditer en priorité les interconnexions (API, réseau, gestion des identités) est plus crucial pour la sécurité que de simplement débattre des mérites intrinsèques du cloud public versus privé.

Le DSI moderne est confronté à un paradoxe constant : comment concilier l’agilité et l’innovation promises par le cloud public avec l’impératif de sécurité et de contrôle absolu sur les données sensibles, traditionnellement assuré par une infrastructure privée ? La réponse standard est devenue le « cloud hybride », un modèle présenté comme la synthèse parfaite des deux mondes. On nous dit de placer nos applications non critiques et nos besoins de scalabilité dans le public, tout en gardant nos joyaux de la couronne bien au chaud dans notre datacenter on-premise.

Pourtant, cette vision simpliste masque une réalité bien plus complexe et risquée. Et si la véritable question n’était pas « public ou privé ? », mais « comment maîtriser les coutures entre les deux » ? L’expérience sur le terrain montre que la majorité des incidents de sécurité et des dérives de coûts ne proviennent pas des infrastructures elles-mêmes, mais des points de jonction : les connexions réseau, les processus de migration, la gestion des identités et les stratégies de connectivité inter-sites. C’est dans ces zones grises, souvent négligées, que se nichent les vulnérabilités les plus insidieuses.

Cet article ne se contentera pas de lister les avantages du cloud hybride. En tant qu’architecte cloud, mon objectif est de vous armer contre les pièges concrets. Nous allons disséquer ces points de jonction critiques, analyser les erreurs de configuration les plus courantes et définir des stratégies pragmatiques pour construire une forteresse hybride, et non une passoire sophistiquée.

Pour naviguer efficacement à travers ces enjeux techniques, cet article est structuré pour aborder chaque point de vulnérabilité et de décision stratégique. Le sommaire ci-dessous vous guidera à travers les étapes clés pour bâtir une infrastructure hybride à la fois flexible et véritablement sécurisée.

Sommaire : Votre guide stratégique pour un cloud hybride sécurisé

- Pourquoi votre connexion entre Cloud public et privé est une passoire pour les hackers ?

- Comment migrer vos applications critiques vers l’hybride sans perte de données ?

- AWS Outposts vs Azure Stack : quelle solution est la moins chère sur 3 ans ?

- L’erreur de configuration réseau qui double le temps de réponse de vos applications

- Quand basculer vos charges de travail vers le public pour absorber un pic de trafic ?

- Pourquoi votre facture de stockage S3 augmente de 20% sans nouvelles données ?

- VPN MPLS ou SD-WAN : quelle technologie pour relier 10 agences sans latence ?

- Comment choisir votre fournisseur Cloud pour éviter le « Vendor Lock-in » ?

Pourquoi votre connexion entre Cloud public et privé est une passoire pour les hackers ?

La promesse d’une infrastructure hybride transparente repose sur une interconnexion parfaite. Or, ce pont entre votre datacenter et le cloud public est souvent le maillon faible de votre stratégie de sécurité. La principale vulnérabilité ne vient pas d’une attaque frontale sophistiquée, mais d’une mauvaise gestion des identités et des accès (IAM). Selon une étude, plus de 68% des entreprises citent le vol d’identifiants comme la tactique d’attaque la plus préoccupante contre les infrastructures cloud. Dans un contexte hybride, ce risque est démultiplié.

L’erreur classique est de maintenir une gestion désynchronisée des identités entre l’annuaire on-premise (comme Active Directory) et les services IAM du cloud public (Azure AD, AWS IAM). Un employé qui quitte l’entreprise peut voir son accès révoqué sur l’AD local, mais son compte de service associé à une application cloud peut rester actif, créant une porte d’entrée béante pour une attaque. La sécurité devient une responsabilité partagée, mais il est de votre devoir de mettre en œuvre des mesures pour combler les lacunes du fournisseur.

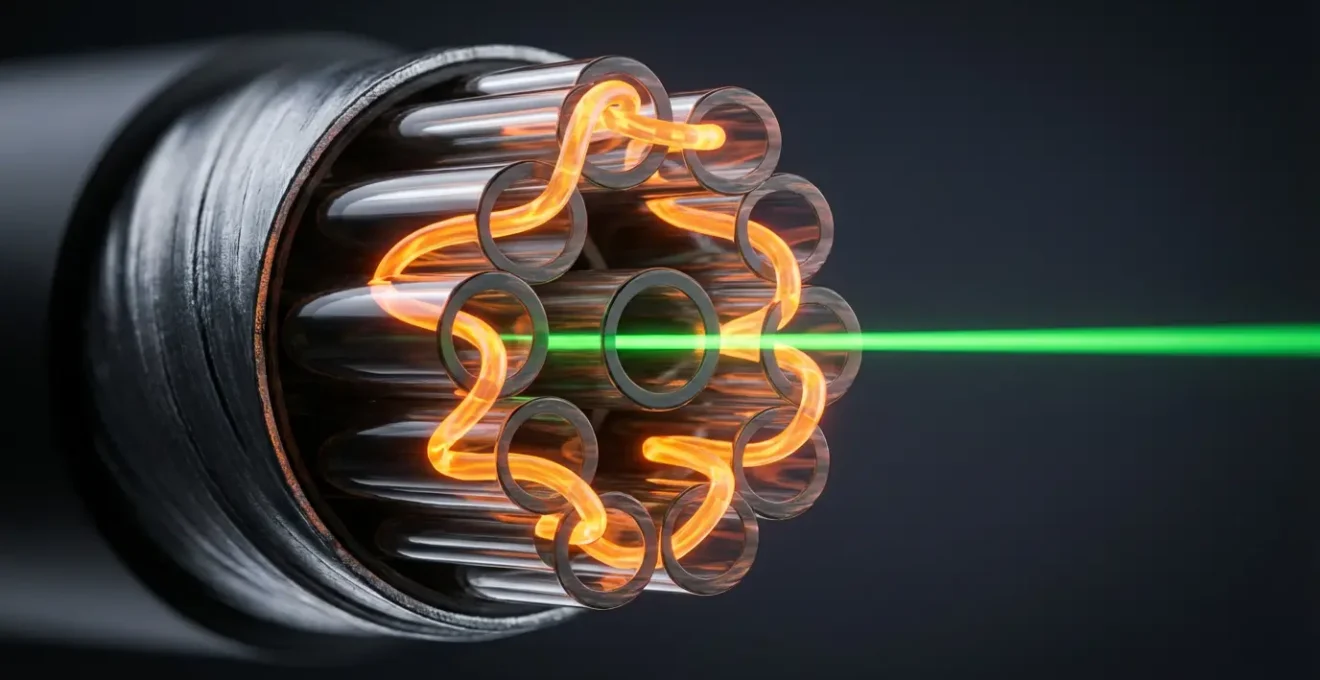

Cette visualisation illustre parfaitement le concept : le pont entre les deux environnements est intrinsèquement fragile. Chaque utilisateur, chaque application qui traverse ce pont représente un vecteur d’attaque potentiel si les politiques de sécurité ne sont pas unifiées et appliquées de manière cohérente des deux côtés. Il est donc impératif d’adopter une solution de fédération d’identité (comme ADFS ou des solutions tierces) pour garantir un « Single Sign-On » (SSO) et une gestion centralisée du cycle de vie des identités sur l’ensemble du périmètre hybride.

Comment migrer vos applications critiques vers l’hybride sans perte de données ?

Migrer une application monolithique critique, développée sur plusieurs années, vers un environnement cloud hybride est une opération à cœur ouvert. La méthode « Lift and Shift », qui consiste à déplacer l’application telle quelle, est souvent un mirage. Elle déplace également la dette technique et les problèmes de performance sans bénéficier de l’élasticité du cloud. Pour les DSI, la question est cruciale, d’autant que la tendance est à l’accélération : on estime que le cloud hybride passera de 3% à 34% des déploiements en France d’ici trois ans.

L’approche la plus sécuritaire et pragmatique est la méthode dite « Strangler Fig Pattern » (le modèle du figuier étrangleur). Plutôt que de remplacer brutalement le monolithe, on vient l’entourer progressivement de nouveaux microservices développés dans le cloud. Chaque nouvelle fonctionnalité, ou chaque refonte d’une fonctionnalité existante, est construite en dehors de l’ancien système, qui est lentement « étranglé » jusqu’à ce qu’il ne reste plus rien de lui. Cette migration progressive minimise les risques d’interruption de service et de perte de données.

Votre plan d’action pour une migration « Strangler Fig » réussie

- Cartographie initiale : Identifiez et documentez précisément toutes les fonctions de l’application monolithique. Priorisez les modules les plus simples ou les plus stratégiques à externaliser en premier.

- Création du proxy : Développez des microservices dans le cloud pour entourer l’application legacy. Mettez en place un proxy ou une façade qui redirigera les appels soit vers le nouveau microservice, soit vers l’ancienne fonction du monolithe.

- Réplication des données : Implémentez une réplication de la base de données en temps réel via des technologies de Change Data Capture (CDC). Cela garantit que les nouveaux et anciens systèmes travaillent sur des données synchronisées.

- Migration fonction par fonction : Migrez les fonctionnalités une par une. Le proxy est mis à jour à chaque étape pour rediriger de plus en plus de trafic vers les nouveaux microservices, sans aucune interruption pour l’utilisateur final.

- Validation de non-régression : Mettez en place des processus de validation stricts à chaque étape, en utilisant des techniques comme le « data hashing » ou des requêtes de rapprochement mathématiques pour garantir qu’aucune donnée n’a été corrompue ou perdue durant la transition.

Cette méthode, bien que plus longue à mettre en œuvre, transforme un projet de migration risqué en une série d’évolutions maîtrisées, assurant la continuité des activités et l’intégrité totale des données critiques.

AWS Outposts vs Azure Stack : quelle solution est la moins chère sur 3 ans ?

Lorsque la décision est prise de construire un cloud privé qui étend véritablement le cloud public dans votre datacenter, deux acteurs majeurs dominent le marché : AWS avec Outposts et Microsoft avec Azure Stack. La question n’est plus seulement technique, elle devient économique. Calculer le coût total de possession (TCO) sur 3 ans est un exercice complexe qui va bien au-delà du simple prix d’achat du matériel. Il faut intégrer les coûts de gestion, de licences logicielles et de trafic réseau.

L’analyse comparative montre des philosophies différentes avec des impacts financiers directs. AWS Outposts fonctionne sur un modèle « as-a-service » pur : AWS vous livre et gère le matériel, qui reste leur propriété. Azure Stack, à l’inverse, est une solution que vous achetez auprès de partenaires hardware (Dell, HPE, Lenovo) et qui requiert plus d’expertise interne pour la gestion.

| Critère | AWS Outposts | Azure Stack |

|---|---|---|

| Modèle de gestion | As-a-Service (AWS gère le matériel) | Plus d’expertise on-premise requise |

| Frais de trafic sortant | Non facturés pour trafic local vers région AWS | Facturés selon utilisation |

| Licences logicielles | Incluses dans l’abonnement | Windows Server/SQL Server en supplément |

| Coût humain | Réduit (gestion AWS) | Élevé (patchs, monitoring hardware) |

| ROI écosystème | Optimal pour environnement AWS existant | Optimal pour environnement Microsoft (.NET, AD) |

Le choix dépend donc largement de votre écosystème existant et de vos compétences internes. Pour une entreprise déjà fortement investie dans l’écosystème AWS, Outposts offre une extension naturelle avec un coût humain réduit. Pour une organisation historiquement basée sur les technologies Microsoft (.NET, Active Directory, SQL Server), Azure Stack peut offrir un meilleur ROI malgré un coût de gestion initial plus élevé, en capitalisant sur les compétences et les licences existantes. La décision doit être guidée par une analyse fine du TCO plutôt que par le seul prix affiché du matériel.

L’erreur de configuration réseau qui double le temps de réponse de vos applications

Dans un environnement hybride, la latence est l’ennemi invisible. Une milliseconde de trop peut dégrader l’expérience utilisateur et impacter le chiffre d’affaires. L’une des erreurs de configuration les plus courantes et les plus coûteuses est le phénomène de « tromboning » réseau. Il se produit lorsque le trafic entre deux machines virtuelles situées dans le même réseau cloud (trafic dit « Est-Ouest ») est inutilement forcé de faire un aller-retour par un équipement de sécurité physique situé dans votre datacenter on-premise.

Ce détour est souvent causé par des tables de routage (User Defined Routes – UDR) mal configurées, qui forcent tout le trafic à passer par le firewall central pour inspection. Bien que l’intention de sécuriser soit louable, le résultat est un doublement, voire un triplement, de la latence pour des communications qui devraient être quasi instantanées. La bonne pratique consiste à utiliser des outils de sécurité natifs au cloud, comme les Network Security Groups (NSG) ou des appliances virtuelles de firewall (NVAs) directement dans le VNet, pour inspecter le trafic Est-Ouest sans quitter l’environnement cloud.

Comme le montre ce schéma, un routage optimisé est un chemin direct. Le tromboning, c’est le détour tortueux et inutile qui pénalise la performance. La clé de la sécurité et de la performance dans un cloud hybride réside dans la micro-segmentation. En concevant des sous-réseaux isolés et en appliquant des politiques de sécurité granulaires directement au niveau des machines virtuelles, on empêche les déplacements latéraux non autorisés sans pour autant sacrifier la performance. La surveillance du trafic doit permettre de savoir d’où il vient et où il va, mais surtout par quel chemin le plus efficient il y parvient.

Quand basculer vos charges de travail vers le public pour absorber un pic de trafic ?

Le « cloud bursting », ou débordement dans le cloud, est l’un des arguments phares du modèle hybride. L’idée est simple : lorsque votre infrastructure privée atteint ses limites de capacité, vous basculez automatiquement les charges de travail excédentaires vers le cloud public, quasi-infiniment scalable. Cependant, la mise en œuvre est loin d’être triviale. La question clé est : « quand déclencher le débordement ? ». Une stratégie réactive, basée sur des seuils d’utilisation CPU à 90%, est déjà un échec. Le temps de provisionner les ressources dans le cloud, le pic de trafic est déjà passé et les clients ont subi des ralentissements.

Une stratégie de cloud bursting efficace doit être prédictive et basée sur des métriques métier, pas uniquement techniques. Par exemple, un site e-commerce ne devrait pas surveiller l’utilisation du CPU de ses serveurs web, mais plutôt le « nombre de paniers actifs » ou le « rythme d’ajout au panier ». Ces indicateurs métier permettent d’anticiper une hausse de charge bien avant que les serveurs ne saturent. On peut alors configurer des Global Load Balancers pour basculer proactivement une partie du trafic (par exemple 20%) vers l’environnement public dès qu’un certain seuil métier est franchi. Ce n’est pas un hasard si près de 84% des organisations utilisant des environnements hybrides le font pour optimiser le placement de charges spécifiques comme l’IA, qui sont par nature sujettes à des pics de demande.

Pour que cette bascule soit fluide, il est essentiel que les données soient accessibles de manière transparente des deux côtés. Des services comme AWS Storage Gateway permettent aux applications on-premise d’utiliser le stockage cloud (comme S3) de manière native via des protocoles standards (NFS, iSCSI). Ainsi, lorsque l’application déborde dans le cloud public, elle retrouve instantanément son jeu de données sans qu’il soit nécessaire de lancer des opérations de copie longues et coûteuses.

Pourquoi votre facture de stockage S3 augmente de 20% sans nouvelles données ?

L’un des mythes du cloud est que le stockage est bon marché et simple. En réalité, une mauvaise gestion des services de stockage objet comme Amazon S3 ou Azure Blob Storage peut entraîner une explosion des coûts, même sans ajout de nouvelles données. Plusieurs « coûts cachés » sont souvent responsables de cette dérive, transformant un avantage économique en un gouffre financier. Ces coûts sont des symptômes d’une mauvaise gouvernance, qui est aussi une faille de sécurité. D’ailleurs, le manque de rigueur est global, puisque seulement 8% des entreprises chiffrent plus de 80% de leurs données sensibles dans le cloud, exposant à la fois leur portefeuille et leur sécurité.

Pour reprendre le contrôle, un audit régulier des coûts cachés est indispensable. Voici les points à vérifier en priorité :

- Le versioning d’objets : Utile pour la récupération de données, cette fonction crée une nouvelle copie de l’objet à chaque modification. Si elle est activée par défaut sur des buckets où les fichiers sont fréquemment écrasés, le coût de stockage peut être multiplié par le nombre de versions conservées. Il faut l’activer uniquement lorsque c’est nécessaire.

- Les « multipart uploads » incomplets : Lorsqu’un fichier volumineux est téléversé, il est découpé en plusieurs parties. Si le processus échoue, ces fragments orphelins restent stockés et facturés. Une politique de cycle de vie (« Lifecycle Policy ») doit être mise en place pour les supprimer automatiquement après quelques jours.

- La mauvaise classe de stockage : Toutes les données n’ont pas la même valeur ni la même fréquence d’accès. Stocker des archives ou des logs rarement consultés en classe « Standard » est un gaspillage. Il faut automatiser la transition de ces « cold data » vers des classes moins chères comme « Infrequent Access » ou « Glacier ».

La maîtrise des coûts de stockage n’est pas une simple optimisation financière. C’est une discipline de gouvernance qui force à connaître ses données, leur cycle de vie et leur criticité, ce qui est le fondement même d’une stratégie de sécurité efficace.

VPN MPLS ou SD-WAN : quelle technologie pour relier 10 agences sans latence ?

Connecter de manière sécurisée et performante plusieurs sites distants à une infrastructure cloud hybride est un défi majeur. Historiquement, le MPLS (Multi-Protocol Label Switching) était la solution reine, offrant des garanties de service (SLA) très fortes et une sécurité intrinsèque grâce à l’isolation du trafic. Cependant, le MPLS est rigide, coûteux et peu adapté aux flux applicatifs modernes qui se dirigent de plus en plus vers le cloud public. Face à cela, le SD-WAN (Software-Defined Wide Area Network) est apparu comme une alternative flexible et économique, capable d’agréger plusieurs types de liens (fibre, 4G/5G, ADSL) et de router le trafic intelligemment en fonction de l’application.

Le débat n’est plus binaire. Une approche hybride de la connectivité, où MPLS et SD-WAN coexistent, est souvent la plus pertinente, comme le montre la croissance de l’adoption du cloud hybride en général : plus de 58% des décideurs IT l’utilisent, signe d’une recherche d’équilibre.

| Critère | MPLS | SD-WAN | Approche Hybride |

|---|---|---|---|

| Garanties SLA | Fortes | Variables | Modulables par flux |

| Coût | Élevé | Optimisé | Équilibré |

| Flexibilité | Rigide | Très flexible | Optimale |

| Sécurité | Isolée par nature | Requiert SASE | Segmentée par application |

| Cas d’usage optimal | VoIP, ERP critique | Navigation, email | Mix selon criticité |

La meilleure stratégie consiste à utiliser le MPLS comme une « autoroute » premium réservée aux flux critiques et sensibles à la latence (comme la VoIP ou les transactions vers l’ERP on-premise). Le SD-WAN, lui, sert de réseau « intelligent » pour tout le reste : le trafic à destination d’Internet et des applications SaaS est routé directement, sans passer par le datacenter central, ce qui améliore les performances. Pour sécuriser ces flux directs, il est indispensable de coupler le SD-WAN à une architecture SASE (Secure Access Service Edge), qui intègre des fonctions de sécurité (firewall, filtrage URL, CASB) directement dans le cloud.

À retenir

- La sécurité d’un cloud hybride se joue à l’intégration, pas à la localisation. La plus grande menace vient des « coutures » mal gérées entre le public et le privé.

- Les configurations par défaut des fournisseurs cloud sont conçues pour la facilité d’usage, pas pour une sécurité maximale. Elles sont souvent des failles en attente d’être exploitées.

- La portabilité applicative et infrastructurelle (via Kubernetes, Terraform) est votre meilleure assurance contre le « vendor lock-in » et la dépendance à un seul fournisseur.

Comment choisir votre fournisseur Cloud pour éviter le « Vendor Lock-in » ?

Le risque ultime d’une stratégie cloud, qu’elle soit publique ou hybride, est le « vendor lock-in » ou l’enfermement propriétaire. C’est la situation où votre infrastructure et vos applications deviennent si dépendantes des services spécifiques et propriétaires d’un fournisseur (AWS, Azure, Google) qu’il devient techniquement complexe et financièrement prohibitif d’en changer. Ce risque est si concret que près de 25% des entreprises envisagent de rapatrier une partie de leurs charges de travail du cloud, souvent en réaction à ce sentiment de perte de contrôle. Éviter cet écueil doit être un principe directeur dès la conception de l’architecture.

La clé est d’adopter une stratégie d’agnosticisme technologique autant que possible. Cela ne signifie pas se priver des services managés à haute valeur ajoutée, mais de les utiliser de manière réfléchie. La première ligne de défense est de standardiser l’orchestration des conteneurs avec Kubernetes. En conteneurisant vos applications et en les gérant via Kubernetes, vous garantissez leur portabilité. Migrer une application de Amazon EKS (le service Kubernetes d’AWS) vers Azure AKS ou Google GKE devient une opération standard, sans avoir à réécrire le code de l’application.

La deuxième ligne de défense est l’Infrastructure-as-Code (IaC) agnostique. Utiliser des outils comme Terraform plutôt que les solutions natives (CloudFormation pour AWS, ARM/Bicep pour Azure) vous permet de décrire votre infrastructure avec un langage unique, capable de provisionner des ressources chez n’importe quel fournisseur. Enfin, il faut privilégier les formats de données ouverts (comme Parquet ou Avro) et les API standards. Par exemple, au lieu d’utiliser une base de données propriétaire, on peut choisir une version open-source (comme PostgreSQL) hébergée en service managé, en s’assurant que les données peuvent être facilement exportées. La stratégie est de toujours isoler les services propriétaires derrière des API internes que vous contrôlez, agissant comme une couche d’abstraction entre votre application et le service du fournisseur.

Pour évaluer la maturité de votre propre infrastructure hybride et identifier les failles potentielles aux points de jonction, une analyse personnalisée de votre architecture par des experts est l’étape suivante logique.