Le « vert » administratif ne suffit plus : la véritable empreinte de votre hébergement se cache dans la fabrication du matériel et la consommation d’eau.

- Un PUE faible cache souvent une surconsommation d’eau potable pour le refroidissement (WUE).

- 78 % de l’impact carbone provient de la fabrication des serveurs, rendant leur longévité plus critique que leur efficacité électrique.

Recommandation : Exigez de votre hébergeur des métriques précises sur la température de bascule en free cooling, le taux d’évaporation et la durée de vie moyenne du parc matériel.

Pour un responsable RSE ou un DSI, choisir un hébergement web « vert » se résume souvent à cocher deux cases : des certificats de garantie d’origine renouvelable pour l’électricité et une participation à des programmes de reforestation. Pourtant, cette approche ne traite que la partie émergée de l’iceberg. Si l’électricité décarbonée est un prérequis, elle masque souvent des réalités physiques beaucoup plus lourdes : des milliers de litres d’eau potable évaporés pour maintenir des salles serveurs à 20°C et des équipements remplacés prématurément pour des gains de performance marginaux.

Le marché abonde d’offres « neutres en carbone » qui reposent sur de la compensation financière plutôt que sur une réduction réelle des flux physiques. La véritable sobriété numérique ne se mesure pas en arbres plantés, mais en efficacité thermodynamique, en litres d’eau (Water Usage Effectiveness) et en années d’utilisation du matériel (Embodied Carbon). Au-delà des discours marketing, il est temps d’auditer la physique réelle de vos données.

Mais si la véritable clé de la réduction d’empreinte n’était pas de chercher le data center le plus neuf, mais celui qui sait faire durer le vieux ? Cet article décortique les mécanismes invisibles de la pollution numérique, du refroidissement adiabatique aux cycles de vie du hardware, pour vous donner les moyens de calculer le coût réel de votre infrastructure.

Nous analyserons successivement les métriques d’efficacité énergétique, les pièges de la consommation d’eau, la valorisation de la chaleur fatale et les stratégies de prolongation de la durée de vie du matériel.

Pour naviguer efficacement dans cette analyse technique, voici les points clés que nous allons aborder.

Sommaire : Audit complet de l’empreinte environnementale serveur

- Pourquoi un PUE de 1.2 est excellent et comment le vérifier chez votre hébergeur ?

- Utiliser l’air extérieur pour refroidir : est-ce possible en été dans le sud ?

- L’erreur d’ignorer les millions de litres d’eau évaporés pour refroidir vos données

- Comment chauffer des piscines ou des bureaux avec la chaleur de vos serveurs ?

- Quand migrer vos données en Norvège ou Islande pour profiter de l’énergie verte ?

- Quand privilégier une blockchain « Proof of Stake » pour réduire votre empreinte carbone ?

- Que faire de vos vieux serveurs pour respecter la réglementation environnementale ?

- Comment prolonger la durée de vie de votre parc informatique de 2 ans sans perte de performance ?

Pourquoi un PUE de 1.2 est excellent et comment le vérifier chez votre hébergeur ?

Le Power Usage Effectiveness (PUE) reste l’indicateur roi pour évaluer l’efficacité énergétique d’un centre de données. Il représente le ratio entre l’énergie totale consommée par le data center et l’énergie réellement utilisée par les équipements informatiques. Un PUE de 1.0 signifierait une efficacité parfaite où chaque watt acheté alimente directement un serveur, sans aucune perte pour la climatisation ou l’éclairage. Cependant, la réalité du marché est bien différente. Alors qu’un PUE de 1.2 témoigne d’une infrastructure hautement optimisée, la moyenne mondiale stagne encore à 1,56, selon l’enquête 2024 de l’Uptime Institute relayée par Statista. Cela signifie que pour beaucoup d’hébergeurs, plus d’un tiers de l’énergie est encore « gaspillé » dans les infrastructures de support.

Il est crucial de ne pas se fier à une déclaration marketing globale. Les géants du secteur eux-mêmes affichent des disparités régionales importantes. Par exemple, Google maintient un PUE moyen impressionnant de 1,09, mais ce chiffre varie significativement selon le climat local, grimpant jusqu’à 1,16 dans des zones chaudes comme l’Alabama. Pour un responsable RSE, l’objectif est d’exiger le PUE spécifique du site hébergeant vos données, et non une moyenne internationale lissée qui masquerait des inefficacités locales.

La vérification doit donc porter sur la granularité de la donnée fournie. Un hébergeur transparent doit être capable de fournir des courbes de PUE en temps réel, corrélées à la charge serveur et à la température extérieure. C’est le premier pas pour distinguer une véritable optimisation énergétique d’un simple affichage de conformité.

Utiliser l’air extérieur pour refroidir : est-ce possible en été dans le sud ?

Le « Free Cooling », qui consiste à utiliser l’air extérieur pour refroidir les serveurs, est souvent présenté comme le graal de l’efficacité énergétique. Sur le papier, cette technique permet de drastiquement réduire l’usage des compresseurs de climatisation énergivores. Cependant, cette méthode se heurte à une limite physique stricte : la température de bascule. Dès que le thermomètre extérieur dépasse un certain seuil, souvent autour de 25°C à 27°C, l’air ambiant ne suffit plus à dissiper la chaleur dense émise par les racks de serveurs modernes. C’est à cet instant précis que le bilan environnemental peut basculer.

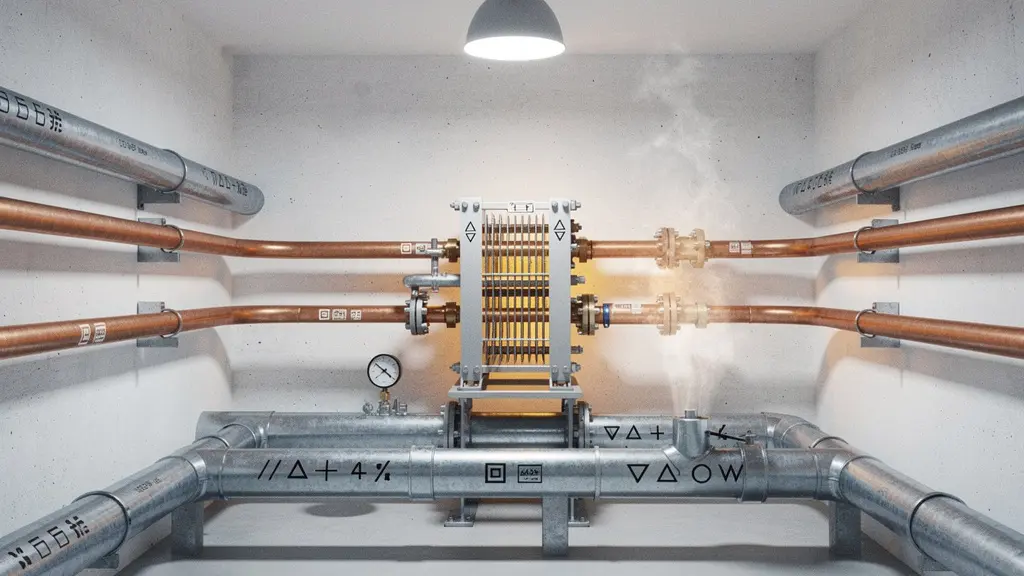

Pour comprendre les implications physiques de ce système, il faut visualiser les équipements impliqués. L’image suivante illustre la complexité mécanique nécessaire pour brasser ces volumes d’air massifs.

Comme on peut le deviner sur cette illustration, l’interaction entre l’air et l’humidité est critique. Lorsque le free cooling ne suffit plus, de nombreux data centers activent des systèmes de refroidissement adiabatique (évaporation d’eau) pour abaisser la température. Les conséquences peuvent être surprenantes. Dans le cas d’un centre de données Microsoft aux Pays-Bas, conçu pour privilégier l’air extérieur, la consommation d’eau a atteint 84 millions de litres en une année, dépassant de quatre fois les prévisions initiales. Cela démontre qu’en période de canicule, ou dans des régions plus chaudes comme le sud de l’Europe, le free cooling peut paradoxalement entraîner une pression hydrique massive si le système de secours repose sur l’eau plutôt que sur des groupes froids en circuit fermé.

L’erreur d’ignorer les millions de litres d’eau évaporés pour refroidir vos données

L’obsession pour le PUE a créé un effet pervers : pour réduire la facture électrique (et améliorer le PUE), de nombreux opérateurs se sont tournés massivement vers l’eau. C’est le concept du Water Usage Effectiveness (WUE), souvent passé sous silence. Le refroidissement par tours aéroréfrigérantes est thermodynamiquement efficace, mais il repose sur un principe de consommation : l’évaporation. En effet, environ 80 % de l’eau des tours de refroidissement s’évapore dans l’atmosphère pour dissiper la chaleur, ce qui représente une perte nette pour le bassin versant local.

Cette consommation est loin d’être anecdotique. À l’échelle mondiale, les data centers ont englouti 560 milliards de litres d’eau en 2023. Dans un contexte de stress hydrique croissant, choisir un hébergeur qui affiche un PUE excellent mais qui « brûle » de l’eau potable pour l’atteindre est un non-sens écologique. Un responsable engagé dans la sobriété numérique doit impérativement demander le WUE de son prestataire. Un chiffre bas (proche de 0) indique généralement l’usage de circuits fermés (chillers), qui consomment plus d’électricité mais préservent la ressource en eau.

Il s’agit donc d’un arbitrage complexe entre énergie et eau. Ignorer ce transfert de pollution revient à optimiser son bilan carbone au détriment des ressources hydriques locales, une forme de « greenwashing par omission » de plus en plus critiquée. La transparence sur les sources d’eau (potable, grise, industrielle) et les taux de restitution est devenue un critère de sélection tout aussi vital que l’origine de l’électricité.

Comment chauffer des piscines ou des bureaux avec la chaleur de vos serveurs ?

Un serveur est, par définition, un radiateur électrique qui effectue des calculs. Près de 100% de l’électricité consommée par un processeur finit par être dissipée sous forme de chaleur. Dans une approche traditionnelle, cette chaleur fatale est considérée comme un déchet qu’il faut évacuer à grands frais énergétiques. Pourtant, dans une logique d’économie circulaire, c’est une ressource précieuse. En France, le gisement est estimé à 3,6 TWh par an, soit de quoi chauffer des centaines de milliers de logements.

Des acteurs innovants comme Neutral-IT transforment cette contrainte en opportunité en décentralisant les data centers. Au lieu de concentrer des milliers de serveurs dans des hangars climatisés, ils installent des mini-centres de calcul directement dans les chaufferies des bâtiments. L’énergie calorifique n’est plus rejetée dans l’atmosphère mais transférée dans les réseaux d’eau chaude sanitaire.

L’image ci-dessous montre comment s’opère ce transfert physique au cœur des installations.

Cette intégration architecturale permet d’atteindre des bilans carbone négatifs sur l’exploitation. En supprimant la climatisation active et en substituant la chaleur serveur à une chaudière gaz ou électrique, on valorise doublement chaque kilowattheure consommé. Pour un DSI, choisir un hébergeur qui pratique la réutilisation de chaleur fatale est l’un des leviers les plus puissants pour réduire le Scope 2 et 3 de son bilan carbone.

Quand migrer vos données en Norvège ou Islande pour profiter de l’énergie verte ?

La délocalisation des données vers les pays nordiques, souvent appelée « Green IT relocation », repose sur un calcul pragmatique : profiter d’un environnement où l’énergie est non seulement 100 % renouvelable (hydroélectrique ou géothermique) mais où le climat permet un refroidissement naturel quasi permanent. En Islande, par exemple, la température moyenne annuelle de 4,5°C rend l’usage de climatiseurs mécaniques superflu la majeure partie de l’année. Le coût du kWh y est également très compétitif, souvent moitié moins cher que la moyenne européenne.

Cependant, cette stratégie ne convient pas à tous les usages. La distance géographique induit inévitablement de la latence. Si vos applications nécessitent des interactions en temps réel (trading haute fréquence, jeux en ligne, applications métier critiques), les quelques dizaines de millisecondes supplémentaires pour un aller-retour vers Reykjavik peuvent dégrader l’expérience utilisateur. En revanche, pour du stockage froid (archivage), de l’entraînement de modèles d’IA ou du rendu 3D, où le temps de calcul prime sur le temps de réponse réseau, la migration est extrêmement pertinente.

Il faut également considérer la résilience des infrastructures. Bien que l’énergie soit verte, la dépendance aux câbles sous-marins pour le transit des données ajoute une couche de risque logistique. La décision de migrer doit donc être le fruit d’une analyse rigoureuse classifiant vos « workloads » selon leur sensibilité à la latence versus leur intensité énergétique.

Quand privilégier une blockchain « Proof of Stake » pour réduire votre empreinte carbone ?

Dans l’écosystème des technologies web modernes, le choix du protocole de consensus pour une blockchain est sans doute la décision ayant l’impact environnemental le plus direct et massif. Le mécanisme historique de « Proof of Work » (PoW), utilisé par Bitcoin, sécurise le réseau par la dépense énergétique brute, mettant les mineurs en compétition de calcul. À l’inverse, le « Proof of Stake » (PoS) sécurise le réseau par l’immobilisation de capital (les jetons), supprimant ainsi la course à la puissance de calcul.

Le passage d’Ethereum au Proof of Stake (The Merge) a démontré l’efficacité radicale de cette transition, réduisant la consommation du réseau de plus de 99 %. Pour un projet numérique intégrant des fonctionnalités Web3, le choix de la blockchain n’est pas anodin : opter pour une solution PoW peut anéantir tous les efforts d’optimisation faits par ailleurs sur l’hébergement web classique.

Le tableau ci-dessous illustre les ordres de grandeur incomparables entre ces technologies.

Ces données mettent en lumière l’écart abyssal de consommation, comme le montre une analyse comparative récente.

| Blockchain | Protocole de consensus | Consommation annuelle estimée | Équivalent pays |

|---|---|---|---|

| Bitcoin | Proof of Work (PoW) | ~130 TWh/an | Comparable à l’Argentine |

| Ethereum (post-Merge) | Proof of Stake (PoS) | Quelques GWh/an | Négligeable |

| Tezos | Proof of Stake (PoS) | ~0,00006 TWh/an | Négligeable |

| Polygon | Proof of Stake (PoS) | ~0,00079 TWh/an | Négligeable |

Si votre projet nécessite impérativement une sécurité de type Bitcoin, des solutions de « Layer 2 » (couches secondaires) existent pour déporter les transactions et réduire l’impact. Mais pour la majorité des applications d’entreprise (traçabilité, certification), le Proof of Stake est aujourd’hui le seul choix compatible avec une stratégie RSE sérieuse.

Que faire de vos vieux serveurs pour respecter la réglementation environnementale ?

La phase de fabrication concentre la majorité écrasante des impacts environnementaux du numérique. Pour un serveur standard, environ 78 % de l’impact environnemental du numérique est généré avant même sa mise sous tension, lors de l’extraction des minerais et de l’assemblage. Se débarrasser d’un serveur fonctionnel après trois ans sous prétexte qu’il est « moins efficace énergétiquement » est souvent une aberration écologique appelée « effet rebond ». Le gain opérationnel électrique compense rarement la dette carbone de fabrication d’une machine neuve.

Lorsque le matériel arrive véritablement en fin de vie, sa gestion devient un enjeu réglementaire et éthique majeur. Les déchets électroniques (DEEE) contiennent des métaux précieux mais aussi des substances dangereuses. La traçabilité du recyclage est impérative pour éviter l’exportation illégale vers des décharges à ciel ouvert.

L’image ci-dessous évoque la minutie requise pour valoriser correctement ces composants en fin de parcours.

Il est essentiel de privilégier des filières de réemploi (reconditionnement pour des usages moins critiques) avant d’envisager le recyclage matière destructif. Un hébergeur responsable doit pouvoir fournir des certificats de destruction ou de réemploi pour chaque numéro de série sorti de son parc.

À retenir

- Le PUE ne mesure que l’électricité : vérifiez aussi le WUE (eau) et le cycle de vie matériel.

- La chaleur fatale est une ressource inexploitée qui peut transformer un data center en chaudière verte.

- Garder un serveur 2 ans de plus réduit drastiquement son empreinte carbone annuelle amortie (Scope 3).

Comment prolonger la durée de vie de votre parc informatique de 2 ans sans perte de performance ?

L’allongement de la durée de vie des équipements est le levier le plus puissant de la sobriété numérique. Passer de 3 à 5 ans, voire 7 ans d’utilisation, divise par deux l’impact carbone annuel lié à la fabrication. Contrairement aux idées reçues, un serveur de 5 ans reste parfaitement capable d’assurer la majorité des tâches web modernes, pour peu que l’architecture logicielle soit adaptée. Le secret réside dans l’optimisation et la « virtualisation dense » plutôt que dans la course à la puissance brute.

Le suréquipement est chronique : on estime souvent que les serveurs tournent à une fraction de leur capacité réelle. Avant d’acheter du neuf, un audit de l’existant permet souvent de libérer des ressources insoupçonnées. C’est ici que l’ingénierie logicielle rencontre la responsabilité écologique.

Plan d’action pour étendre la longévité serveur : 5 étapes

- Mesurer le Server Loading Efficiency (SLE) réel — un PUE de 1,10 peut masquer un SLE de seulement 45 %, indiquant que plus de la moitié de la capacité serveur est inutilisée et que l’optimisation logicielle est prioritaire.

- Déployer la virtualisation dense et le right-sizing — utiliser des conteneurs et désactiver les cœurs inutilisés pour maintenir les performances applicatives sur du matériel existant tout en améliorant le ratio performance/watt.

- Appliquer les mises à jour de microcode et firmware — les optimisations de gestion d’énergie intégrées aux correctifs fabricants peuvent améliorer l’efficacité énergétique de 15 à 20 % sans remplacement physique.

- Calculer le point de bascule énergétique (embodied carbon vs surconsommation) — déterminer après combien d’années la surconsommation électrique d’un serveur ancien dépasse l’empreinte carbone de fabrication d’un serveur neuf.

- Monitorer en continu les indicateurs IT actionnables (téraflops/kWh) — l’étude 2025 MD.C/ADEME/France Datacenter propose des métriques pour quantifier l’impact réel des workloads et arbitrer objectivement entre prolongation et remplacement.

Lancez dès aujourd’hui l’audit complet de votre hébergeur en réclamant ces métriques précises pour aligner enfin votre infrastructure IT avec vos engagements climatiques.