La promesse du Serverless—ne payer que ce que vous consommez—s’effondre sans une ingénierie financière rigoureuse.

- Les cold starts et l’orchestration distribuée sont les principaux vecteurs de gaspillage invisible sur vos workloads.

- L’observabilité et la portabilité ne sont pas des luxes techniques mais des garde-fous budgétaires essentiels.

Recommandation : Adopter une approche FinOps technique en traitant chaque milliseconde de latence et chaque requête comme une ligne de coût directement impactant la marge brute.

Recevoir une facture de 5 000 € à cause d’une boucle infinie ou d’une fonction Lambda mal configurée est le cauchemar récurrent du lead développeur moderne. Pourtant, le Serverless vend le rêve de l’élasticité à coût nul : vous ne payez que ce que vous utilisez. Dans la réalité, sans une discipline architecturale stricte, les coûts d’orchestration, de latence et d’observabilité explosent silencieusement.

L’erreur classique consiste à croire que la migration vers le cloud public suffit à garantir des économies. C’est oublier que chaque milliseconde de cold start, chaque appel inter-service et chaque gigaoctet transféré génèrent une ligne de coût. Cet article adopte une approche contre-intuitive : traiter la réduction des dépenses cloud non comme une contrainte opérationnelle, mais comme un requisit non-fonctionnel guidant vos choix d’architecture.

Nous explorerons huit dimensions critiques, des optimisations techniques des fonctions Lambda aux stratégies financières des modèles SaaS, en passant par les limites physiques du cloud centralisé pour l’industrie 4.0.

Pour ceux qui préfèrent le format visuel, la vidéo suivante propose une immersion technique dans une architecture full event-driven serverless sur Google Cloud, illustrant concrètement les patterns évoqués dans ce guide.

L’optimisation des coûts serverless traverse trois couches distinctes : la performance brute des runtimes, l’architecture logicielle des services, et la stratégie économique des modèles de licensing. Pour naviguer efficacement entre ces dimensions, ce guide structuré vous permettra d’identifier rapidement les leviers d’action les plus impactants pour votre contexte spécifique.

Sommaire : optimisation serverless et pilotage des coûts cloud

- Pourquoi vos fonctions Lambda mettent 3 secondes à démarrer et comment corriger ?

- L’erreur de lancer une architecture micro-services sans outils de traçabilité

- Comment éviter la facture surprise de 5000€ à cause d’une boucle infinie ?

- Fonction monolithique ou nano-services : quel découpage pour la maintenance ?

- Quand utiliser des conteneurs standards pour pouvoir quitter AWS ou Azure demain ?

- SaaS ou Licence perpétuelle : quel modèle financier pour une PME en croissance ?

- Coût d’acquisition vs Valeur Vie : quel ratio garantit la survie de votre SaaS ?

- Pourquoi le Cloud est trop lent pour les voitures autonomes et l’usine 4.0 ?

Pourquoi vos fonctions Lambda mettent 3 secondes à démarrer et comment corriger ?

Le cold start représente la période d’initialisation où le runtime prépare l’environnement d’exécution avant de traiter votre première requête. Cette phase, qui peut atteindre plusieurs secondes selon le runtime et les dépendances, ne facture pas uniquement du temps CPU : elle dégrade l’expérience utilisateur et force souvent une sur-provisionnement compensatoire. Pour comprendre les mécanismes d’optimisation, il est essentiel de visualiser la différence entre les phases d’initialisation statique et l’exécution dynamique.

Comme le montre cette métaphore visuelle, la transition entre l’état froid et chaud dépend crucialement de la configuration mémoire et de la taille du package déployé. Une analyse comparative des stratégies d’élimination des cold starts révèle deux approches principales aux compromis distincts.

| Critère | Simultanéité provisionnée (Provisioned Concurrency) | SnapStart | À la demande + optimisations (code/config) |

|---|---|---|---|

| Objectif principal | Éliminer les cold starts en gardant des environnements pré-initialisés | Réduire fortement l’initialisation via snapshot d’un environnement préchauffé | Réduire la latence sans payer une capacité « toujours chaude » |

| Coût quand le trafic est faible | Coût additionnel car la capacité provisionnée est facturée même si peu utilisée | Pas de capacité provisionnée à payer (mais contraintes/limites fonctionnelles possibles) | Coût minimal, mais cold starts possibles |

| Quand c’est le bon choix | Trafic prévisible, endpoints critiques, SLO stricts et stabilité de la charge | Apps sensibles à la latence avec bursts imprévisibles, besoin de réduire INIT sans planification fine | Trafic irrégulier, tolérance à une latence « premier hit », optimisation progressive |

| Contraintes à vérifier | Configuration par version/alias; dimensionnement et scaling à gérer | Fonctionne sur versions publiées; compatibilité runtime/limitations à vérifier | Risque de latence au démarrage selon dépendances et initialisation |

La documentation AWS détaille que la simultanéité provisionnée représente un investissement fixe qui ne se justifie économiquement que lorsque le trafic dépasse un seuil de rentabilité calculé sur vos SLOs.

Plan d’action pour éliminer les cold starts : optimisations Lambda

- Augmenter la mémoire allouée à la fonction (CPU proportionnel) pour réduire le temps d’initialisation.

- Réduire la taille du package de déploiement (dépendances strictement nécessaires) pour accélérer le démarrage.

- Minimiser le code exécuté à l’initialisation (INIT) et éviter les traitements lourds au démarrage.

- Réutiliser les connexions (ex. base de données) et privilégier les mécanismes de pooling (ex. proxy).

- Mettre en place une stratégie « à chaud » (provisioned concurrency) couplée à une observabilité fine des latences d’initialisation.

L’erreur de lancer une architecture micro-services sans outils de traçabilité

Distribuer votre logique métier en dizaines de fonctions serverless sans système de traçabilité distribuée, c’est naviguer à l’aveugle dans un océan de latences cachées. Lorsqu’une requête traverse cinq services avant de répondre, identifier quel appel génère du surcoût ou une erreur devient impossible sans une corrélation unique entre les traces, les logs et les métriques. L’absence d’observabilité conduit à multiplier les redondances de capacité « par précaution », gonflant artificiellement la facture.

Comme le soulignent les experts du domaine dans une analyse récente :

Chez Splunk, nous avons fait le choix d’une instrumentation native avec OpenTelemetry, sans agents propriétaires

– Stéphane Estevez, LeMagIT — « OpenTelemetry doit (encore) gagner en stabilité »

Cette approche par standards ouverts permet de corréler les performances techniques avec les coûts par requête, transformant l’observabilité en outil FinOps. La mise en œuvre suit une progression logique.

Votre feuille de route pour le traçage distribué avec OpenTelemetry

- Définir ce que vous cherchez à expliquer (latence, erreurs, goulets d’étranglement) et quelles requêtes « métier » doivent être traçables de bout en bout.

- Instrumenter le chemin critique (création de spans) et propager le contexte de trace entre services pour relier tous les appels d’une même requête.

- Standardiser les attributs (ex. service, opération, environnement) pour rendre les traces filtrables par équipe, feature ou client.

- Choisir une stratégie de sampling (ne pas tout tracer en production) et ajuster selon les SLO et les budgets d’observabilité.

- Exporter traces/logs/métriques vers un collecteur ou une plateforme et valider la cohérence (corrélation trace ↔ logs ↔ métriques).

- Mettre en place des dashboards et des alertes orientées parcours (end-to-end) plutôt que des métriques isolées par service.

Comment éviter la facture surprise de 5000€ à cause d’une boucle infinie ?

L’architecture event-driven serverless est vulnérable aux boucles de rétroaction infinies où une fonction invoque un service qui déclenche à nouveau la fonction. Sans mécanisme de circuit breaker ou de budget d’arrêt d’urgence, cette récursion peut générer des millions d’invocations en quelques heures, transformant une erreur de code en catastrophe financière. La prévention repose sur une approche FinOps proactive intégrant des garde-fous techniques et organisationnels.

Cette métaphore du fusible s’applique parfaitement aux contrôles d’usage qui doivent interrompre automatiquement tout traitement dépassant les seuils définis. La mise en place de ces sécurités passe par cinq étapes concrètes.

Points clés à vérifier : alertes, budgets et contrôles d’usage (approche FinOps)

- Définir des seuils (coûts/usage) par environnement (prod, préprod, dev) et par périmètre (compte, service, tags).

- Mettre en place des notifications précoces (dépassement réel ET prévisionnel) pour détecter une boucle de retries, un flood d’événements ou une explosion de requêtes.

- Séparer les droits et instaurer des contrôles : limiter régions, types de ressources et capacités de création selon les rôles.

- Ajouter des actions de remédiation (ex. restrictions IAM/SCP ou arrêt de ressources non critiques) quand un seuil est franchi.

- Industrialiser la revue post-incident : identifier le driver de coût (orchestration, transferts, appels inter-services) et créer une règle/limite pour éviter la récidive.

Fonction monolithique ou nano-services : quel découpage pour la maintenance ?

La tentation de découper chaque endpoint en fonction serverless distincte (nano-services) génère souvent une complexité d’orchestration qui dépasse les gains d’élasticité. Lorsque la majorité du temps d’exécution est consacrée aux transferts réseau entre fonctions plutôt qu’au traitement métier, l’architecture devient un frein à la fois technique et économique. Le retour d’expérience de Prime Video illustre parfaitement cette réalité.

Prime Video : réduction de coûts en regroupant des composants distribués

Retour d’expérience relayé par DevClass (publié le 5 mai 2023) décrivant un cas où l’orchestration et les échanges entre composants distribués ont dominé la facture à grande échelle. L’équipe a packé des composants dans un processus unique (sur EC2/ECS), supprimant une partie des coûts d’orchestration et de transferts intermédiaires, et rapportant une baisse de coûts d’infrastructure de plus de 90% ainsi qu’une amélioration des capacités de mise à l’échelle.

Cette étude de cas démontre que la granularité excessive peut dégrader les performances et les coûts simultanément. Pour éviter cet écueil, les heuristiques du Domain-Driven Design offrent un cadre de découpage pertinent.

Checklist essentielle pour découper sans exploser la charge cognitive (bounded contexts DDD)

- Cartographier le langage métier : repérer les termes qui changent de sens selon les équipes (signal de frontière).

- Définir un premier découpage large (contextes plus gros) dans le cœur métier, puis affiner seulement quand les conflits de règles et de vocabulaire persistent.

- Couper sur les invariants : isoler les règles qui interagissent peu et qui évoluent à des rythmes différents.

- Mesurer le « bavardage » : si un flux nécessite des appels réseau constants entre deux nano-services, envisager un regroupement (module/monolithe) pour limiter latence + coûts d’intégration.

- Choisir un mode d’intégration explicite entre contextes (API/événements/contrats) et éviter le partage implicite (base de données partagée, objets communs).

Quand utiliser des conteneurs standards pour pouvoir quitter AWS ou Azure demain ?

Le lock-in propriétaire représente un risque économique à long terme : l’impossibilité de négocier ses tarifs ou de migrer vers une infrastructure plus adaptée. Les conteneurs standards (Docker/OCI) offrent une portabilité technique qui préserve votre capacité à arbitrer entre fournieurs, même si cela implique une charge opérationnelle supérieure. La décision entre FaaS natif et conteneurs dépend d’un arbitrage entre agilité immédiate et liberté stratégique future.

| Dimension | Conteneurs standards (Docker/OCI) | FaaS serverless natif | Hybride « noyau + satellites » |

|---|---|---|---|

| Portabilité | Élevée (même image sur plusieurs clouds / on-prem, selon les services autour) | Plus faible (événements, IAM, runtimes et services managés diffèrent) | Élevée sur le cœur (conteneurs), plus faible sur la « glue » (fonctions) |

| Coût d’exploitation | Plus d’opérations (build, patching, runtime, scaling) selon la plateforme | Faible ops mais coûts variables et parfois surprenants (orchestration, appels, egress) | Ops concentrées sur le cœur; fonctions utilisées pour les points où l’élasticité vaut le coût |

| Performance/latence | Stable, dépend du dimensionnement; pas de cold start « FaaS » | Risque de cold start selon runtime et dépendances; excellente élasticité | Chemins critiques dans conteneurs; événements et tâches ponctuelles en fonctions |

| Stratégie anti-lock-in | Standardiser le packaging + interfaces; limiter l’usage de services trop spécifiques | Encapsuler via adaptateurs; éviter de disperser la logique métier au sein de services propriétaires | Ports & adapters + cœur portable; adaptateurs cloud pour événements, identité, files, etc. |

L’analyse comparative de Cloudflare démontre que les conteneurs conservent un avantage de portabilité critique pour les workloads à longue durée de vie. Pour concrétiser cette portabilité sans sacrifier la maintenabilité, l’architecture hexagonale fournit un cadre robuste.

Les étapes de votre audit d’architecture hexagonale (Ports & Adapters)

- Isoler le domaine (logique métier) dans un cœur sans dépendances vers le cloud ou des frameworks d’infra.

- Définir des ports (interfaces) pour les I/O : persistance, messagerie, APIs externes, stockage objet, etc.

- Implémenter des adaptateurs par fournisseur (ex. adaptateur « file cloud A », adaptateur « file cloud B ») en gardant le même port.

- Ajouter un adaptateur « test/mocking » (in-memory) pour rendre les tests rapides et éviter la dépendance à une infra réelle.

- Documenter le contrat des ports et imposer une règle de dépendances : le domaine ne dépend jamais des adaptateurs.

SaaS ou Licence perpétuelle : quel modèle financier pour une PME en croissance ?

Le choix entre modèle SaaS (OpEx récurrent) et licence perpétuelle (CapEx initial) impacte directement la trésorerie et l’agilité d’une PME en phase de croissance. Si le SaaS offre une entrée en matière à coût réduit, l’accumulation des abonnements crée une pression budgétaire continue qui peut devenir problématique lors des levées de fonds ou des phases de consolidation. Les récentes évolutions du marché montrent une tendance inflationniste marquée.

En effet, selon Gartner, les tarifs SaaS de plusieurs grands fournisseurs ont augmenté de 10 à 20% en 2025, accentuant la nécessité d’une gouvernance FinOps étendue au-delà de l’infrastructure pour englober les logiciels tiers. Cette inflation oblige à réévaluer le total cost of ownership sur trois à cinq ans plutôt que de se concentrer sur le seul coût d’acquisition initial.

Des entreprises comme Priceline ont illustré l’importance de centraliser la visibilité des coûts SaaS et de refacturer aux départements consommateurs pour restaurer la responsabilité financière. Cette logique FinOps appliquée aux logiciels permet de comparer objectivement la valeur générée par un outil SaaS versus une solution hébergée en propre, en intégrant les coûts cachés d’intégration et de formation.

Coût d’acquisition vs Valeur Vie : quel ratio garantit la survie de votre SaaS ?

L’économie unitaire d’un SaaS dépend de l’équilibre entre le coût d’acquisition d’un client (CAC) et la valeur qu’il génère sur sa durée de vie (LTV). Lorsque l’infrastructure serverless devient une part significative des coûts de production, chaque optimisation technique impacte directement le LTV en réduisant les coûts de service. Inversement, une architecture mal optimisée peut rendre un client non rentable malgré un revenu récurrent apparent.

Les benchmarks industriels établissent un seuil de survie clair : un ratio LTV:CAC « sain » est typiquement de 3:1 ou plus (la valeur vie doit être au moins 3× le coût d’acquisition). Pour atteindre cet objectif, il est indispensable de tracer les coûts d’infrastructure jusqu’au niveau du tenant individuel.

Feuille de route pour passer d’une facture cloud globale à un coût par tenant

- Normaliser les exports de facturation pour permettre une analyse multi-fournisseurs et multi-équipes (approche FOCUS).

- Définir une clé d’allocation « tenant/client » (ex. tag, account, project, cost category) et s’assurer qu’elle est présente sur les ressources facturées.

- Séparer coûts directs (calcul, stockage, DB dédiées) et coûts partagés (réseau, observabilité, contrôle) et décider d’une règle de refacturation (au prorata usage, requêtes, CPU, etc.).

- Produire un indicateur mensuel « coût par tenant » et le comparer au revenu par tenant pour identifier les clients non rentables (LTV en baisse).

- Coupler cette allocation au pilotage produit (feature costing) : prioriser les optimisations serverless là où elles améliorent le plus la marge brute et donc le LTV/CAC.

À retenir

- La latence technique (cold start, orchestration) se traduit directement en coût financier et en marge dégradée.

- L’observabilité distribuée est un impératif de contrôle budgétaire, pas uniquement technique.

- L’architecture monolithique bien conçue peut surpasser les nano-services en coûts et maintenabilité à grande échelle.

Pourquoi le Cloud est trop lent pour les voitures autonomes et l’usine 4.0 ?

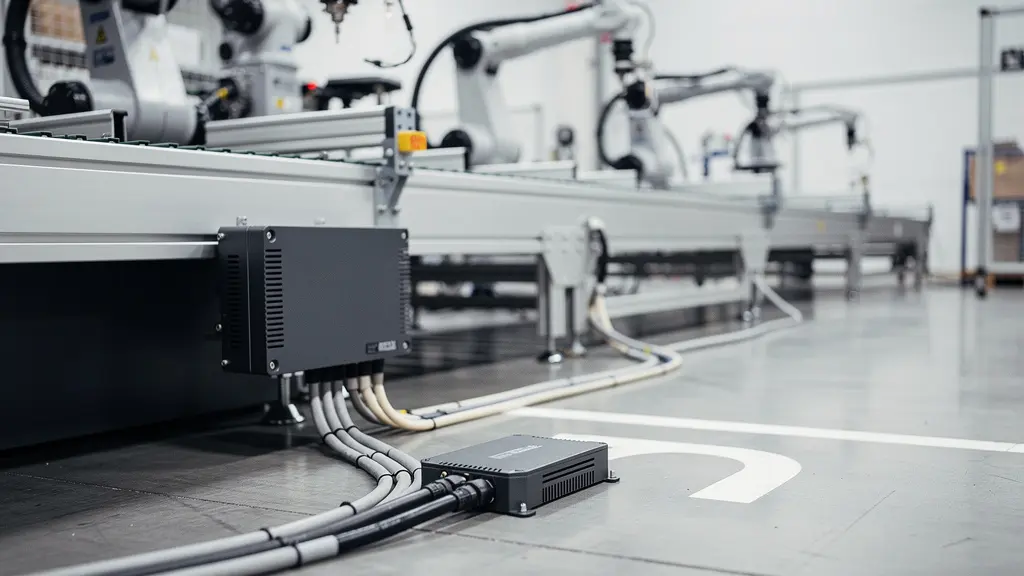

Les architectures cloud centralisées atteignent leurs limites physiques lorsque les applications requièrent une latence inférieure à la milliseconde, typique des systèmes de conduite autonome ou des boucles de contrôle industrielles en temps réel. Dans ces scénarios, l’aller-retour vers une région cloud distante, même optimisé, introduit une latence incompatible avec les exigences de sécurité et de précision. L’Edge computing devient alors non pas une option de performance, mais une contrainte de viabilité.

Cette illustration met en évidence la nécessité de rapprocher le calcul des sources de données. Pour l’industrie 4.0, où les communications URLLC (Ultra-Reliable Low-Latency Communication) exigent des temps de réponse de l’ordre de la milliseconde, seul le traitement en périphérie permet de garantir la stabilité des systèmes cyber-physiques. La stratégie d’optimisation consiste à répartir intelligemment la charge entre edge et cloud.

Plan d’action pour réduire la latence en rapprochant l’exécution (Edge)

- Identifier les chemins « temps réel » (SLO en millisecondes) et distinguer ce qui peut être asynchrone (batch, analytics, reporting).

- Déplacer la logique légère et fréquente au plus près des utilisateurs/objets (filtrage, routage, personnalisation, contrôles simples) pour réduire les allers-retours réseau.

- Garder dans le cloud central les traitements lourds non critiques à la milliseconde (agrégation, entraînement ML, stockage long terme).

- Mesurer et itérer : instrumenter la latence bout-en-bout et valider que le déplacement à la périphérie réduit réellement la latence perçue.

- Appliquer une logique de coûts : payer à l’exécution (quand c’est possible) et éviter de sur-provisionner de l’infrastructure « juste pour la pointe ».

L’optimisation des architectures serverless et distribuées exige une vision globale où la technique et la finance convergent. En maîtrisant les cold starts, en implémentant une observabilité fine, et en arbitrant stratégiquement entre edge et cloud, vous transformez l’infrastructure d’un centre de coûts en levier de compétitivité.

Évaluez dès maintenant votre architecture actuelle à l’aune de ces critères de coût et de latence pour identifier les premières optimisations à implémenter.