L’infrastructure d’Internet n’est pas un « cloud » immatériel, mais un territoire maritime tangible et contesté, où la moindre rupture physique a des conséquences géopolitiques majeures.

- Les activités de surveillance militaire près des câbles, notamment russes, ne sont plus de la fiction mais des actes de guerre hybride.

- La propriété de ces artères numériques par les GAFAM (Google, Meta) remet en question la souveraineté des États et la neutralité du net.

Recommandation : Pour un investisseur ou un stratège, analyser la dépendance géographique des flux de données n’est plus une option, mais une nécessité pour anticiper les risques de rupture.

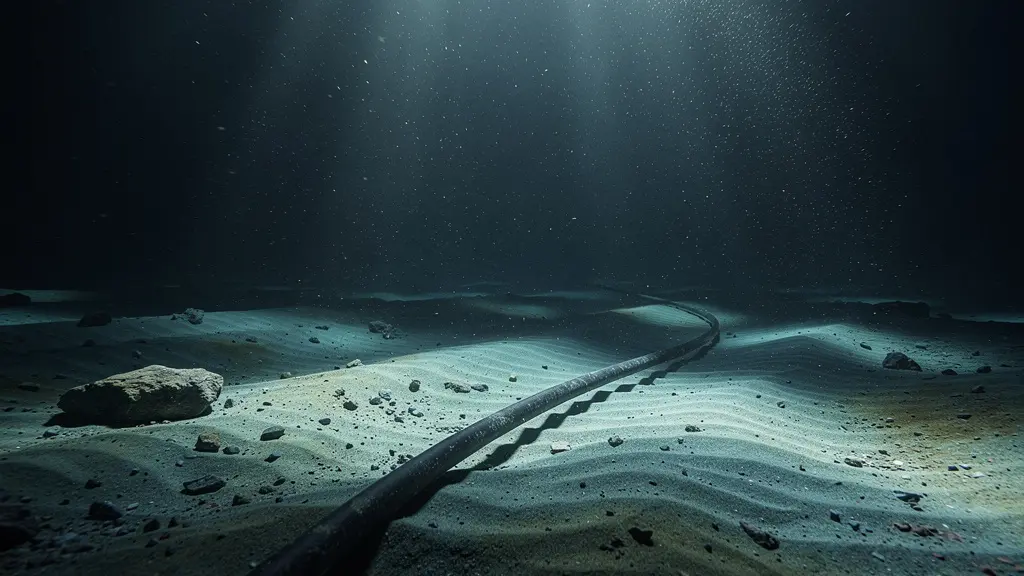

L’idée d’un Internet mondial flottant dans un « cloud » éthéré est une des métaphores les plus puissantes et les plus trompeuses de notre époque. Nous imaginons nos données transitant par satellite, dans un ballet immatériel au-dessus de nos têtes. La réalité est bien plus prosaïque, et infiniment plus stratégique : elle repose au fond des océans. En effet, près de 99% du trafic internet mondial transite par plus de 500 câbles sous-marins, véritables artères de la civilisation numérique. Cette infrastructure physique, invisible au quotidien, est le théâtre d’une nouvelle forme de géopolitique où les États, les méga-corporations et les armées se disputent le contrôle des flux.

Alors que la plupart des analyses se concentrent sur les menaces logicielles comme les cyberattaques, elles ignorent souvent la vulnérabilité la plus fondamentale : la matérialité de ces câbles. Une coupure, qu’elle soit accidentelle ou intentionnelle, n’est pas un simple incident technique. C’est un événement aux répercussions économiques et stratégiques potentiellement dévastatrices. La véritable question n’est plus de savoir « si » une rupture majeure peut survenir, mais de comprendre « comment » cet écosystème physique est devenu une ligne de front silencieuse. Cet article propose une plongée dans la géographie du cyberespace, en analysant les câbles non comme des tuyaux, mais comme des territoires contestés.

Nous allons explorer comment des puissances étatiques cartographient ces infrastructures pour une potentielle guerre hybride, pourquoi la réparation d’un simple câble prend des semaines, et comment la prise de contrôle de ces autoroutes de l’information par Google et Facebook redéfinit les règles de la souveraineté. En comprenant la matérialité de l’Internet, nous décrypterons les nouveaux rapports de force qui régissent notre monde connecté.

Sommaire : Les artères sous-marines de l’internet mondial

- Comment les navires russes ou chinois cartographient nos câbles pour une potentielle guerre hybride ?

- Navires câbliers : pourquoi faut-il 3 semaines pour réparer une coupure au milieu de l’Atlantique ?

- Google et Facebook propriétaires des câbles : quel risque pour la neutralité du net ?

- L’erreur de passer par le mauvais câble qui coûte des millions aux traders haute fréquence

- Marseille ou Djibouti : quels sont les nouveaux carrefours stratégiques de la data mondiale ?

- Pourquoi le streaming vidéo représente 80% du trafic internet mondial ?

- Quand migrer vers un Cloud souverain pour respecter les nouvelles normes européennes ?

- Comment concevoir une architecture réseau qui résiste à une coupure de fibre majeure ?

Comment les navires russes ou chinois cartographient nos câbles pour une potentielle guerre hybride ?

La menace qui pèse sur les câbles sous-marins a changé de nature. Historiquement, les ruptures étaient majoritairement accidentelles, causées par des ancres de navires ou des catastrophes naturelles. Aujourd’hui, la menace est devenue intentionnelle, stratégique et militaire. Des nations comme la Russie et la Chine ne se contentent plus d’espionnage électronique ; elles s’engagent dans une cartographie offensive des fonds marins, traitant les câbles comme des cibles prioritaires en cas de conflit. Cette « territorialisation » du cyberespace transforme ces infrastructures passives en lignes de front actives.

L’activité suspecte de certains navires spécialisés est un secret de polichinelle dans les cercles de défense. Le contre-amiral Andrew Lennon, alors officier supérieur des sous-marins de l’OTAN, a été particulièrement direct à ce sujet, déclarant :

Nous assistons désormais à une activité sous-marine russe à proximité de câbles sous-marins que je ne pense pas avoir jamais vue.

– Contre-amiral Andrew Lennon, Officier supérieur des sous-marins de l’OTAN

Cette activité n’est pas anodine. Le cas du navire espion russe Yantar est emblématique. Officiellement navire de recherche océanographique, il appartient en réalité au GUGI, la Direction principale de la recherche en haute mer de la marine russe. Équipé de submersibles capables de plonger à 6000 mètres, il peut non seulement localiser précisément les câbles, mais aussi potentiellement y poser des dispositifs d’écoute ou des charges explosives. Son stationnement prolongé près de câbles critiques au large de l’Irlande en novembre 2024 a été interprété comme un acte de guerre hybride, une démonstration de force visant à signaler à l’Europe sa vulnérabilité physique. L’objectif est clair : en cas de crise majeure, la capacité à sectionner ces artères vitales pourrait paralyser l’économie et les communications d’un pays ou d’un continent entier.

Navires câbliers : pourquoi faut-il 3 semaines pour réparer une coupure au milieu de l’Atlantique ?

Face à une coupure de câble, la réaction instinctive est d’imaginer une solution technologique rapide. La réalité est un processus industriel lourd, maritime et étonnamment artisanal qui crée un goulot d’étranglement logistique mondial. Si une réparation en elle-même prend en moyenne 6 à 10 jours, ce délai n’inclut pas le temps de transit du navire câblier vers la zone de la rupture, qui peut ajouter une à deux semaines selon la localisation. Cette lenteur s’explique par la rareté des moyens et des compétences.

Le processus de réparation est une opération de haute mer complexe. Il faut d’abord localiser la rupture avec une précision de quelques mètres, ce qui se fait en envoyant des impulsions lumineuses depuis la station d’atterrissement. Ensuite, le navire câblier utilise un grappin pour remonter les deux extrémités du câble, qui peuvent reposer à des milliers de mètres de profondeur. Une fois à bord, le travail le plus critique commence : la soudure des fibres optiques, un travail d’orfèvre réalisé par un technicien hyperspécialisé appelé « jointer ». Chaque fibre, aussi fine qu’un cheveu, doit être parfaitement alignée et fusionnée, le tout dans les conditions parfois difficiles de la haute mer.

Le véritable défi est un problème de ressources. Il n’existe qu’une centaine de navires câbliers dans le monde pour entretenir un réseau de plus d’1,3 million de kilomètres. Comme le souligne une analyse de la flotte, face aux 200 ruptures annuelles mondiales en moyenne, la disponibilité de ces navires et, plus encore, des jointers qualifiés, constitue une vulnérabilité majeure. Des entreprises comme Louis Dreyfus Armateurs peuvent projeter un navire en 48 heures, mais si la flotte est déjà engagée sur d’autres réparations à l’autre bout du monde, le délai d’intervention s’allonge inexorablement, laissant des régions entières avec une connectivité dégradée.

Google et Facebook propriétaires des câbles : quel risque pour la neutralité du net ?

Une transformation silencieuse mais radicale a modifié la propriété des autoroutes de l’information. Historiquement, les câbles sous-marins étaient financés par des consortiums d’opérateurs télécoms nationaux. Aujourd’hui, les géants du numérique (GAFAM), principaux consommateurs de bande passante, sont devenus les premiers bâtisseurs et propriétaires de ces infrastructures. Cette privatisation de l’épine dorsale d’Internet pose des questions fondamentales sur la neutralité du net et la souveraineté numérique.

Cette prise de contrôle est massive. Les GAFAM ne se contentent plus de louer de la capacité ; ils financent et possèdent leurs propres câbles pour sécuriser leurs flux de données et optimiser leurs services. Le tableau ci-dessous, basé sur les données de l’industrie, illustre cette domination croissante. Il met en lumière comment des entreprises comme Google et Meta (Facebook) contrôlent non seulement le contenu mais aussi les contenants.

| Entreprise | Nombre de câbles | Type de propriété | Capacité contrôlée |

|---|---|---|---|

| Google (Alphabet) | 33 | 17 exclusifs, 16 partagés | Câble Dunant 250 Tb/s |

| Meta (Facebook) | 16 | 2 exclusifs, 14 consortiums | 2Africa 180 Tb/s |

| Microsoft | 8 | Majoritairement consortiums | Marea 160 Tb/s |

| Amazon | 5 | Consortiums uniquement | En expansion |

Selon les données de TeleGeography, Alphabet (Google) détient déjà une participation dans 33 câbles sous-marins, dont 17 en propriété exclusive. Cette verticalisation de l’infrastructure est un avantage compétitif énorme, mais elle crée un risque systémique. Comme le souligne Camille Morel, chercheuse à l’Institut d’études de stratégie et de défense, cette situation peut « peser sur la neutralité du Net du fait du lien de propriété qui les relie aux câbles ». En théorie, rien n’empêcherait ces acteurs de prioriser leurs propres flux de données au détriment de ceux de leurs concurrents, ou de négocier des accords d’interconnexion qui favorisent leurs services, créant un Internet à deux vitesses où le propriétaire de l’infrastructure dicte les règles.

L’erreur de passer par le mauvais câble qui coûte des millions aux traders haute fréquence

Dans l’univers du trading haute fréquence (HFT), le temps n’est pas de l’argent : il est l’argent. Chaque milliseconde, voire microseconde, gagnée ou perdue dans la transmission d’un ordre d’achat ou de vente peut se traduire par des millions de dollars de profit ou de perte. Dans ce contexte, la géographie physique des câbles sous-marins n’est pas un détail technique, mais une arme stratégique. La latence, c’est-à-dire le temps de parcours du signal, devient le facteur décisif, et le choix du « bon » câble est une obsession.

La lumière voyage dans la fibre optique à environ deux tiers de sa vitesse dans le vide. La distance physique est donc un ennemi. Les traders cherchent les routes les plus directes entre les places boursières, comme New York et Londres, ou Chicago et Francfort. Un câble qui suit une trajectoire plus courte de quelques centaines de kilomètres offre un avantage concurrentiel absolu. C’est pourquoi des investissements colossaux sont consentis pour construire de nouvelles routes optimisées. Par exemple, le câble Marea, financé par Microsoft et Meta, offre une capacité de 160 Tb/s sur une route plus méridionale et donc plus directe entre la Virginie (États-Unis) et Bilbao (Espagne), devenant un atout majeur pour les flux transatlantiques.

Les opérateurs et les hubs qui peuvent garantir une latence ultra-faible attirent ces flux financiers à haute valeur ajoutée. Des câbles de nouvelle génération comme le SMW6 arrivant à Marseille promettent une latence de bout en bout inférieure à 50 millisecondes vers les hubs asiatiques, un chiffre qui semble instantané pour un humain mais qui représente une éternité pour un algorithme. Pour un fonds HFT, acheminer accidentellement ses ordres via un câble plus ancien, plus long ou plus congestionné est une erreur stratégique qui peut anéantir sa rentabilité. La guerre pour la vitesse est donc aussi une guerre pour le contrôle des chemins de fibre les plus courts, transformant la cartographie des fonds marins en un enjeu financier de premier plan.

Marseille ou Djibouti : quels sont les nouveaux carrefours stratégiques de la data mondiale ?

En géopolitique classique, la maîtrise des « choke points » (points d’étranglement) maritimes comme le détroit d’Ormuz ou le canal de Suez est essentielle. La géographie du cyberespace a ses propres points névralgiques : les villes côtières où atterrissent et s’interconnectent les câbles sous-marins. Ces hubs sont les nouveaux carrefours du monde numérique, et parmi eux, des villes comme Marseille ou Djibouti sont devenues des pivots stratégiques mondiaux.

Marseille, par sa position géographique exceptionnelle, est le point de convergence naturel entre l’Europe, l’Afrique, le Moyen-Orient et l’Asie. C’est une porte d’entrée et de sortie pour des continents entiers. Cette position lui a permis de connaître une croissance exponentielle. Selon les projections, Marseille passera du 7e au 5e rang mondial des hubs de données, avec 18 câbles connectant 57 pays. Des projets d’envergure comme les câbles 2Africa (porté par Meta) et SEA-ME-WE 6 renforcent encore cette centralité. L’investissement de 400 millions d’euros par Digital Realty pour transformer la ville, y compris la reconversion spectaculaire de l’ancienne base sous-marine allemande en data center (MRS3), symbolise cette « territorialisation » de la donnée : un lieu de guerre physique devient un nœud de communication numérique.

De même, Djibouti, à l’entrée de la mer Rouge, est le point d’atterrissement de la quasi-totalité des câbles desservant l’Afrique de l’Est. Ce petit pays a transformé sa position géographique en un atout stratégique majeur, devenant un hub de données incontournable pour toute la région. La concentration de tant d’infrastructures en un seul lieu est à la fois une force et une immense vulnérabilité. Une instabilité politique, un acte de sabotage ou une catastrophe naturelle à Marseille ou Djibouti pourrait avoir des conséquences en cascade, perturbant les communications de dizaines de pays simultanément. La maîtrise de ces « choke points » numériques est donc un enjeu de souveraineté et de sécurité globale.

Pourquoi le streaming vidéo représente 80% du trafic internet mondial ?

L’explosion de la demande en bande passante, qui pousse à la construction de toujours plus de câbles, a une cause principale : la vidéo. Le streaming vidéo, qu’il s’agisse de plateformes comme Netflix, YouTube ou de la visioconférence, est de loin l’usage le plus gourmand en données. Il représente aujourd’hui environ 80% de l’ensemble du trafic Internet mondial, exerçant une pression constante sur l’infrastructure physique sous-jacente.

Cette hégémonie de la vidéo n’est pas seulement un phénomène d’usage ; elle a des conséquences directes sur la géopolitique des câbles. Les principaux fournisseurs de contenu sont aussi les plus grands consommateurs de capacité. Des acteurs comme Netflix (qui représente à lui seul près de 20% du trafic mondial), Google (avec YouTube, environ 13%) et Meta (Facebook/Instagram, 7.5%) ont un besoin vital de garantir une expérience utilisateur fluide et sans latence. C’est cette nécessité qui les a poussés à investir massivement dans leurs propres câbles, comme nous l’avons vu précédemment, afin de maîtriser l’ensemble de la chaîne de diffusion.

Cette demande exponentielle a plusieurs impacts directs sur l’infrastructure :

- Multiplication des câbles : Le nombre de câbles en service a presque doublé en moins de dix ans pour absorber ce flux.

- Augmentation de la capacité : Les nouveaux câbles sont conçus pour des débits autrefois inimaginables. Le câble Anjana de Meta, prévu pour fin 2024, vise par exemple une capacité de 480 Tb/s.

- Déploiement de CDN : Pour réduire la charge sur les câbles transocéaniques, les plateformes déploient des Content Delivery Networks (CDN), des serveurs de cache situés au plus près des utilisateurs pour stocker localement les contenus les plus populaires.

En somme, nos habitudes de consommation de films, de séries et de vidéos en ligne façonnent directement la carte mondiale des infrastructures numériques, justifiant des milliards d’euros d’investissement et redessinant les routes stratégiques de la donnée.

Quand migrer vers un Cloud souverain pour respecter les nouvelles normes européennes ?

Face à la domination des hyperscalers américains (Amazon Web Services, Microsoft Azure, Google Cloud) et aux lois extraterritoriales comme le CLOUD Act américain, l’Europe tente de promouvoir le concept de « cloud souverain ». L’idée est de garantir que les données des citoyens et des entreprises européennes soient hébergées et traitées sur le sol européen, à l’abri des ingérences étrangères. Cependant, cette quête de souveraineté numérique se heurte à un paradoxe physique fondamental : celui des câbles sous-marins.

Une entreprise peut choisir une solution de cloud certifiée, avec des data centers situés en France ou en Allemagne, pensant ainsi se conformer aux normes de protection des données comme le RGPD. Mais que se passe-t-il lorsque ces données doivent transiter vers un autre continent ? Elles empruntent inévitablement des câbles sous-marins. Or, une grande partie de l’infrastructure transatlantique est soit américaine, soit financée et contrôlée par des entreprises américaines. Le signal, bien que chiffré, passe physiquement par une infrastructure qui peut tomber sous le coup de la loi américaine.

Cette réalité crue est parfaitement résumée par un expert en souveraineté numérique dans une analyse des paradoxes du cloud européen. Il souligne que même si les données sont hébergées localement, leur transit international les expose :

Les données sont hébergées en Europe mais leur transit via des câbles américains les expose au CLOUD Act. La souveraineté s’arrête là où le câble commence.

– Expert en souveraineté numérique, Analyse des paradoxes du cloud européen

La migration vers un cloud souverain est donc une démarche nécessaire pour des raisons de conformité et de contrôle, mais elle ne doit pas faire illusion. La véritable souveraineté ne peut être atteinte qu’en considérant l’ensemble de la chaîne de valeur de la donnée, y compris sa couche de transport physique. Cela implique pour l’Europe de soutenir la construction de nouvelles routes de câbles sous contrôle européen, afin de garantir une indépendance non seulement au niveau du stockage (le data center), mais aussi au niveau du transport (le câble).

À retenir

- L’Internet est une infrastructure physique : 99% du trafic passe par des câbles sous-marins, ce qui en fait une infrastructure critique tangible et vulnérable aux ruptures physiques, qu’elles soient accidentelles ou intentionnelles.

- Les GAFAM redéfinissent la souveraineté : En devenant les principaux propriétaires des nouveaux câbles, Google et Meta contrôlent non seulement le contenu mais aussi les autoroutes de l’information, posant un défi direct à la neutralité du net et à la souveraineté des États.

- La résilience passe par la diversification géographique : La concentration des câbles dans des hubs stratégiques comme Marseille crée des points d’étranglement. La seule défense est une architecture réseau qui diversifie les routes physiques pour éviter une dépendance à un seul câble ou un seul point d’atterrissement.

Comment concevoir une architecture réseau qui résiste à une coupure de fibre majeure ?

Face à la matérialité et à la vulnérabilité de l’épine dorsale d’Internet, la résilience n’est pas un luxe mais une nécessité. Pour une entreprise dont l’activité dépend de la connectivité internationale ou pour un État soucieux de sa sécurité, concevoir une architecture réseau capable de survivre à une coupure majeure est un impératif stratégique. Il ne s’agit pas d’empêcher les ruptures, qui sont inévitables, mais de minimiser leur impact en construisant un système capable de se reconfigurer dynamiquement.

Plusieurs stratégies, souvent combinées, permettent de renforcer cette résilience. Elles vont de la duplication matérielle pure à des approches logicielles plus agiles. Le tableau suivant compare les principales approches en termes d’avantages, de limites et de coût relatif, offrant une vision claire des compromis à faire.

| Approche | Avantages | Limites | Coût relatif |

|---|---|---|---|

| Redondance matérielle | Fiabilité maximale | Très coûteux | €€€€ |

| Diversité de routes | Protection géographique | Complexité accrue | €€€ |

| Résilience logicielle (BGP/SD-WAN) | Flexibilité, adaptation rapide | Dépendance aux routes existantes | €€ |

| Backup satellite (Starlink) | Indépendance totale | Latence élevée, débit limité | €€ |

L’approche la plus fondamentale est la diversité des routes. Elle consiste à s’assurer que le trafic critique ne dépend pas d’un seul câble ou d’un seul point d’atterrissement. Cela signifie contracter de la capacité sur plusieurs câbles distincts qui suivent des trajets géographiques différents et atterrissent dans des villes différentes. Couplée à la résilience logicielle, notamment via le protocole BGP (Border Gateway Protocol) qui dirige le trafic sur Internet, ou des solutions de SD-WAN (Software-Defined Wide Area Network), cette diversité permet de basculer quasi instantanément le trafic d’une route coupée vers une route opérationnelle. Les solutions satellites, bien qu’offrant une indépendance totale des infrastructures terrestres, restent une solution de secours en raison de leur latence plus élevée et de leur débit encore limité par rapport à la fibre.

Plan d’action : auditer la résilience de votre connectivité

- Cartographie des points de contact : Listez tous les câbles et points d’atterrissement dont dépend votre trafic international critique. Identifiez les dépendances uniques.

- Inventaire des contrats de transit : Collectez les accords avec vos fournisseurs de transit IP. Spécifient-ils une diversité de routes physiques ?

- Analyse de cohérence : Confrontez votre besoin de disponibilité (SLA) avec le niveau de redondance physique réel de vos fournisseurs. Y a-t-il un écart ?

- Évaluation des scénarios de rupture : Simulez l’impact de la coupure d’un câble majeur (ex: celui qui porte 80% de votre trafic). Quel est le chemin de basculement ? Quel est le temps de convergence ?

- Plan de diversification : Établissez un plan pour combler les « trous » en contractant de la capacité sur des routes géographiquement distinctes ou en envisageant un backup satellite pour les services les plus critiques.

Pour sécuriser vos flux de données et anticiper les chocs géopolitiques, l’audit de vos dépendances aux infrastructures physiques n’est plus une option, mais une nécessité stratégique. Agir aujourd’hui, c’est se prémunir contre la paralysie de demain.